このコラムでは、過去10年(2011年~2021年)のAI/データサイエンス市場の主要イベントやトレンドを振り返りつつ、今後の市場課題やニーズについての仮説をご紹介していきます。前編では過去10年の振り返りを、後編では過去の動向を踏まえた今後の課題と、この先LTSが考えているサービスについてご紹介できればと思います。

なお、この記事で取り扱う内容はDX領域の中でも、AIやデータサイエンスに関するイベントのみのご紹介であり、AIについては第3次AIブーム以降のみにフォーカスしておりますので、予めご了承ください。

また、今回の記事では専門用語が多数出てきますので、個別の注釈は控えさせていただきます。気になる方はご自身で調べてみてください。

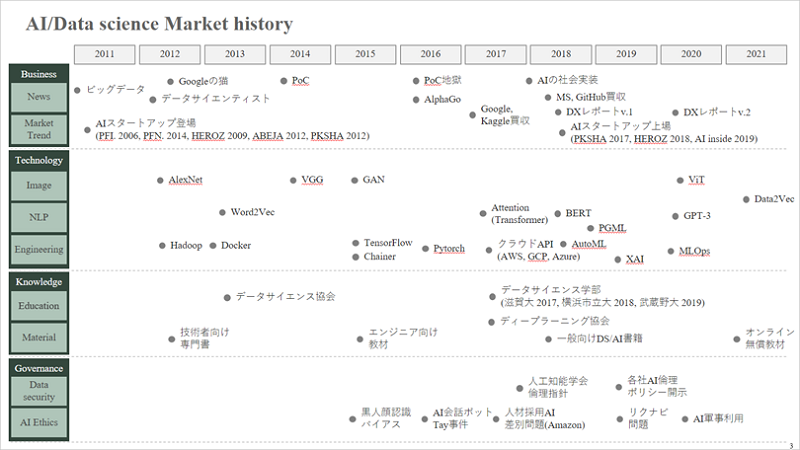

2011年に「ビッグデータ」や「データサイエンス」という言葉が普及し始め、2012年に深層学習が技術的革新を起こしてから約10年が経過しました。

当初、ビッグデータやデータサイエンスは研究開発や技術検証の側面で利用されることが多かったのですが、その後の周辺ツールの普及や技術者が増えてきたことにより、社会実装やビジネスでの利用を前提とした取り組みが増加してきました。その一方で、様々な問題も発生しておりその対策が検討されています。

ここからは、この10年間で起きた様々なイベントを①ビジネス、②テクノロジー、③ナレッジ、④ガバナンスの4つのトピックに分けてご紹介していきます。

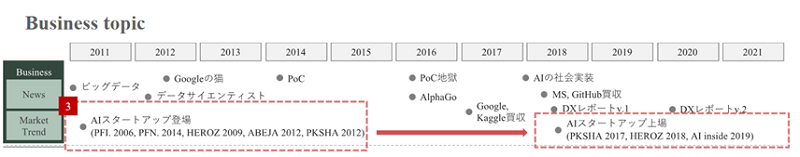

ビジネストピック:DXの登場によりAIがより大規模な取り組みへ発展

①AIのビジネス適用の可能性の拡大

まずはビジネストピックについてです。

2011年頃からIT関係者の多くがたびたび目にしたり聞いたりする機会が出始め、その後バズワードとなったキーワードに「ビッグデータ」があります。また、同時期にデータ活用をするための人材として「データサイエンティスト」という言葉も登場し、将来的なデータサイエンティスト不足が大きな話題となりました。さらに翌年2012年には、「Googleの猫」が話題となり、これらのブームに拍車をかけた様に見えます。

Googleの猫とはGoogleが2012年に、深層学習によって初めてAIが猫の認識に成功したことを発表して大きな話題となった出来事です。AIが猫や人を認識した画像が出回り、AIのビジネス適用の可能性が広がったことで話題となりました。

このように、大量のデータを最新の技術で解析すると、ビジネス上の新しい知見の獲得や人間の様な認知の獲得できるという(やや誤った)理解が普及し、2011年~2013年の間にビジネストピックとして各所で取り上げられました。

②DXの登場によるAIのビジネス適用の促進

そして2016年以降は、社会実装を前提としたAIが次々と登場してきています。一方で、技術実証(以下、PoC)の乱発によるいわゆるPoC地獄も発生しました。多大な時間、コストをかけてPoCを繰り返しているにも関わらず、実務適用に至らずに力尽きてしまう企業が多く見受けられるようになりました。

それらの反省から、技術先行ではなく、適切な課題設定と技術選定をもとにプロジェクト設計をする企業が増えていき、2017年末から2018年頭頃から地に足のついた社会実装が増えてきた印象があります。

この間も引き続き、様々なニュースがメディアに登場し、データサイエンス・AI市場は盛り上がりを見せていました。

Googleが開発した、人間のプロ囲碁棋士に初めて勝ったAI囲碁プログラムAlphaGOの登場も話題となりました。皆さんの記憶にもまだ残っているのではないでしょうか。

また、海外ではGoogleによるKaggle(機械学習モデルの開発をコンペ形式で開催するプラットフォーム)の買収や、マイクロソフトによるGitHub(コード共有/共同作業プラットフォームサービス)の買収などもこの時期に行われています。

国内では経済産業省が2018年にDXレポートを公表し、「DX」という言葉もこの頃から話題となっています。AIやデータサイエンスがより大規模な取り組みへと発展していったのは、DXを実現するための手段として、AI・クラウド・IoT・5G・サイバーセキュリティなどの様々な技術が語られ、DXの文脈に統合されていった背景があるからではないかと思います。

さらにDXについては、従来のITの概念も混在するようになり、現在は全てがDXで語られるという状態になっています。

DXの概念については、「日本のDXは闇鍋状態」という言葉で、いろいろなDXの概念が混在した日本のDXの分かりにくさを解説している面白い記事がありますので、興味のある方はこちらをご覧ください。

https://www.slideshare.net/TokorotenNakayama/dx-240495124

③AIスタートアップ企業の飛躍的な登場から現在の市場動向

AIのビジネス適用の可能性が広がったことにより、AI関連のスタートアップ企業も数多く登場しました。市場が盛り上がりを見せる2012年以前から次々とスタートアップ企業の創業が始まっており、2013年頃には創業間もない数十名規模の企業でも、大企業との業務・資本提携により巨額資金調達に成功し注目を集めました。そして、その後2018年前後に上場しているのが大きな流れとなっています。

2018年頃の上場時、各社の株価は高い市場価格がついており、その後もしばらくは盛り上がりを見せていましたが、現在は落ち着いていて、社会実装に向けて着々と各社動いている状況なのではないかと推測します。

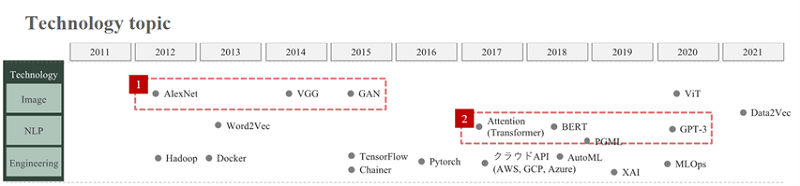

テクノロジートピック:技術発展によるAIの対応タスクの複雑化・多様化

①画像処理の精度向上とタスクの多様化

続いてはテクノロジートピックです。

先ほどのビジネストピックでGoogleの猫について触れましたが、2012年から2015年は主に深層学習の一種であるCNN(Convolutional Neural Network)を用いた画像系AIの精度が大幅に進化した期間です。

2012年の段階では、ネットワークを複雑化・大規模化することでAIの精度向上を図る研究が進み、画像の分類や対象の識別といったタスクの精度が大幅に向上しました。

2012年の画像認識の認識率を競うイベントでは、これまで人間が特徴量を作り込み精度をあげてきたのに対して、CNNを適用することで圧倒的な精度向上を実現したAlexNetが優勝して話題となりました。その後の2014年の同イベントでは、AlexNetと同様CNNを使用しつつ、さらにネットワーク構造を複雑化したモデルのVGG が2位となっています。この様にネットワークをさらに深く、複雑にすることでタスク精度を向上する手法が次々と提案されていきました。

その後は、実務適用を見据えて精度を維持しつつ、モデルをダウンサイズ化する研究であったり、画像分類に加え、画像生成や画像合成(GAN)へとタスクの応用範囲は多様化していきました。

②苦戦から飛躍的発展を遂げた自然言語処理

そして2017年から2020年は、自然言語処理(NLP)の技術が大きく発展した期間です。画像系の精度向上が進んだ2012年から2015年の間にも、自然言語処理(NLP)の取り組みは行われていましたが、技術的な苦戦状態が続きなかなかブレークスルーに至りませんでした。

しかし、2017年に登場した深層学習モデルのtransformerを皮切りに、自然言語領域(NLP)が大幅に発展していきました。さらに自然言語の領域でも学習済みのモデルを利用することで、学習精度や効率が大幅に改善しました。そして、画像系と同様に分類タスクだけでなく、要約や文章生成の研究も行われるようになってきています。

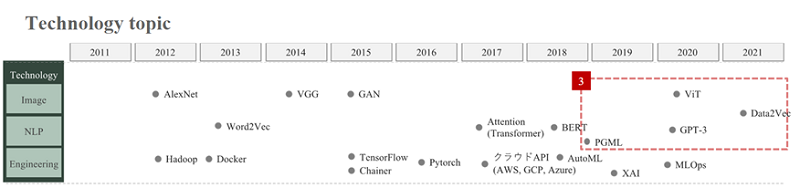

③複数のインプットからスキルを学習するAIの登場

2017年頃までは、AIにより多くのデータを投入すればAIは全てを学習してより良いものを出力してくれるという、全自動データドリブンの深層学習の思想が中心でしたが、2018年から研究のトレンドが変わってきている様に感じます。

2018年以降は、ドメイン知識(対象とする業界・業務特有の知識や知見)に基づいた深層学習の設計の研究が増えてきており、ネットワークにビジネス側のドメイン知識を何らかの形で盛り込むことで、そこまで大規模なビッグデータでなくても精度が出るような研究が進んでいます。

さらに、深層学習以前の2000年代前後に登場したデータマイニングのテクニックと最近の深層学習の手法を融合することで、さらなる精度向上が図られています。

また、画像系と自然言語系、音声系を併せたマルチモーダル化の研究も進み、画像、テキスト、音声といった複数のインプットからスキルを学習できるなど、応用的なテーマにも発展していっているのが最近の動向です。

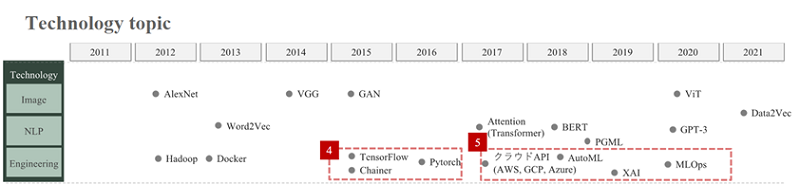

④オープンソース・フレームワークの登場で深層学習の技術が普及

エンジニアリングに関しては、2015年から2016年にかけて、深層学習のオープンソース・フレームワークが次々と登場しました。Google のTensorFlow やFacebook(現:Meta)のPytorchなど米国の主要IT企業が開発したフレームワークが業務で適用されるようになりました。日本製のChainerもこのタイミングで登場しており、一部の研究機関でしか利用できなかった技術が、幅広い技術者に普及していきました。

⑤誰でも簡単にAIが利用できる時代に

さらに2017年になると、AIモデルを簡易に利用できるクラウドAPIや、2018年には機械学習モデルの設計や構築の自動化(AutoML)サービスが登場し、MLやAIに関する深い知識がなくても、簡単にAIを利用することができるようになりました。

誰でも簡単に利用できるようになった一方で、深い問題設計をせずPoCを開始してしまい、プロジェクトの頓挫を繰り返す PoC地獄という弊害もこの時期から発生しています。

そして2020年頃には、PoCだけでなく、実業務において継続的に価値を発揮し続けるための方法論として、MLOpsに関する考察や研究も登場してきました。

ナレッジトピック:専門家だけの技術・知識から広く一般社会に教育が普及

①技術や知識習得の壁

3つ目はAI/データサイエンスの知識や学習に関するナレッジトピックです。

2012年頃の学習教材は、技術者向けの専門書が中心で独学による勉強はやや厳しい環境でした。ネットなどでは「はじめての○○」というタイトルの書籍がよく入門書として紹介されているのですが、とても分厚く中身は数式と難しい記号ばかりで、これがデータサイエンス入門の挫折のきっかけになったという話も聞いています。

②データサイエンス人材の教育活動の普及

そして2017年頃にようやく本当の意味で「はじめての」という一般向けのAI/データサイエンスの書籍や教材・研修などが登場してきました。

また、大学機関でのデータサイエンス学部の設立や講座の開講など、データサイエンス人材の強化に向けた教育活動が増えていき、より一般向けの学習の機会が普及してきました。

特に2020年以降は、新型コロナウイルスによりオンライン学習が普及したタイミングでもあり、企業や大学から無料教材がたくさん解放されていきました。

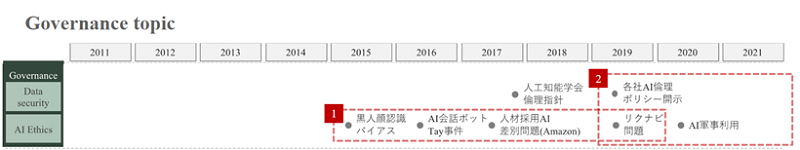

ガバナンストピック:AIの普及がもたらした倫理問題

①問題行動を起こすAIの誕生

最後はガバナンストピックです。

社会実装での適用が進みAIの活用範囲が拡大するに従って、2015年からは倫理的な問題やセキュリティに関する問題なども多発し、何らかの規制・ガバナンスの観点が必要となってきました。

海外では、顔認識ソフトウェアが黒人の顔をしばしば認識できないという黒人顔認識バイアス問題から始まり、AIにTwitterなどのサービスでユーザとの会話を通して言葉を学習させていく取り組みでは、ユーザがAIに不適切な言葉を学習させたことにより問題発言を繰り返すAIが誕生してしまった AI会話ボットTay事件 などが起きています。

②健全なAIの活用に向けた対応

日本では、2019年にリクナビ登録者のAIによる内定辞退率の予測データが、第三者の企業に販売されるリクナビ問題が話題となり、個人情報の定義やCookieデータの取り扱いの議論へ発展しました。 このあたりの諸問題を踏まえて、2019年頃に協会や企業ではAI倫理ポリシーやデータ活用ポリシーなどをweb上で開示するようになりました。しかし、AI技術はまだ発展途上であり今後も適用範囲は拡大していくため、継続的なガイドラインの検討が必要です。

以上が過去10年の(2011年~2021年)のAI/データサイエンス市場の主要イベントやトレンドの振り返りです。

後編では、過去10年を踏まえた今後の課題や求められる人材、そしてLTSデータ分析チームが検討しているサービスをご紹介していますので、ぜひこちらもご覧ください。

データサイエンティストにご興味のある方は、LTSデータサイエンティストの連載コラムもぜひご覧ください。

エディター

CLOVER編集部員。メディアの立ち上げから携わり、現在は運営と運用・管理を担当。SIerでSE、社会教育団体で出版・編集業務を経験し、現在はLTSマーケティングGに所属。趣味は自然観賞、旅行、グルメ、和装。(2021年6月時点)